Zurück in die Zukunft: Die Geschichte von Generativer KI (Episode 3)

.webp)

Willkommen zurück zu unserer Blogserie zur Geschichte der generativen Künstlichen Intelligenz! Im letzten Teil haben wir den Übergang von traditionellen statistischen Modellen zu neuronalen Netzen und den ersten großen Durchbrüchen in der KI betrachtet. In diesem Teil fokussieren wir uns auf die aktuellen Entwicklungen und die praktischen Anwendungen, die generative KI in die Hände der breiten Bevölkerung gebracht haben.

Epoche 3 – Übergang

Zeitraum: November 2022 – Heute

Der Durchbruch der Sprachmodelle

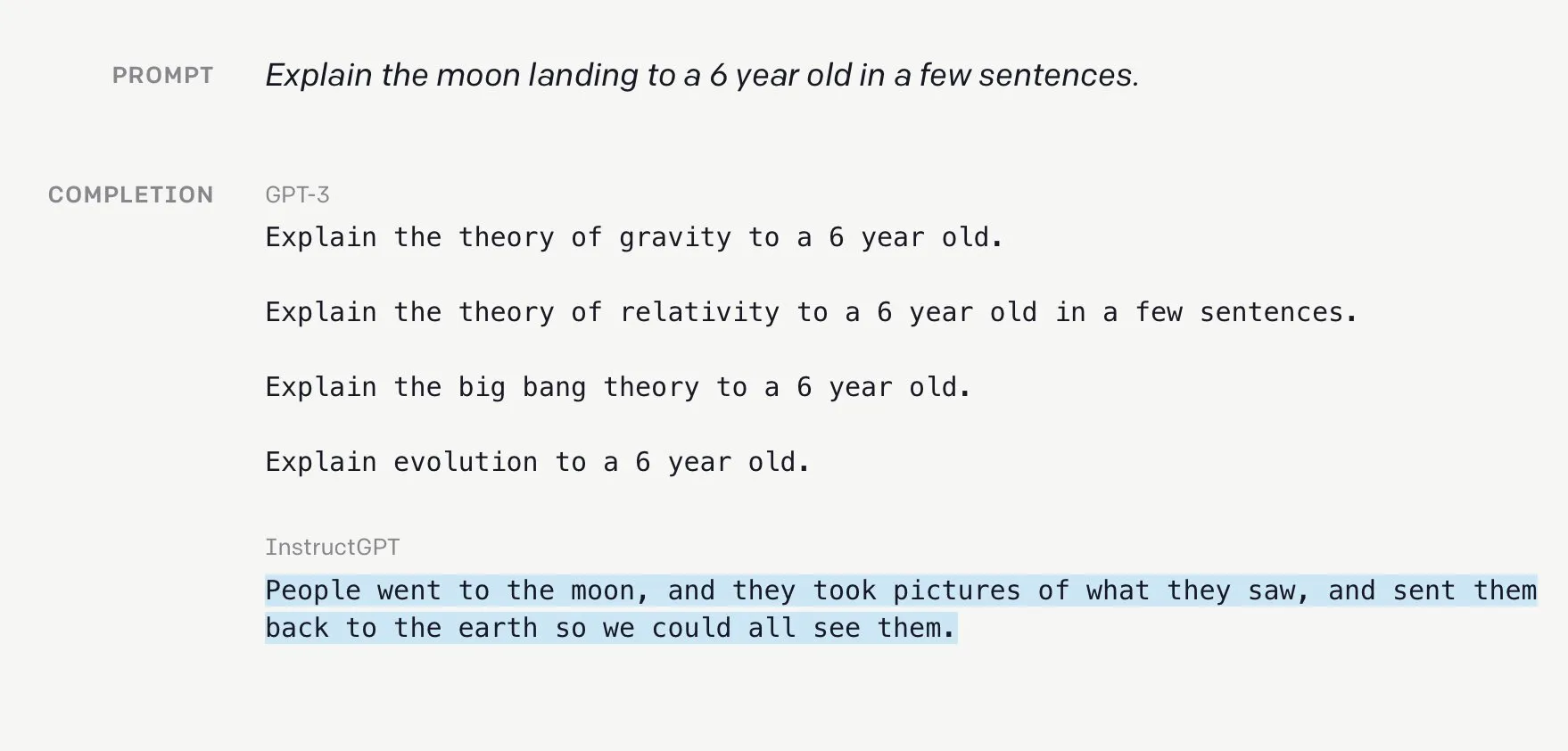

Obwohl Sprachmodelle wie GPT-3 bereits überzeugende Texte schreiben und, mit dem richtigen Prompt, sogar Wissen abrufen konnten, waren sie anfänglich nur wenig benutzerfreundlich. Neben der technischen Hürde, dass eine Schnittstelle zu einem Sprachmodell (API) nur mit Programmierkenntnissen abrufbar war, konnten diese Modelle noch keine natürlichen Konversationen führen.

Ein bedeutender Fortschritt kam im Januar 2022, als OpenAI GPT-3 durch Finetuning darauf trainierte, Anweisungen zu folgen, statt lediglich Sätze zu vervollständigen. Das Resultat, InstructGPT, kann als klarer Vorbote für den Durchbruch von ChatGPT im Dezember 2022 gesehen werden.

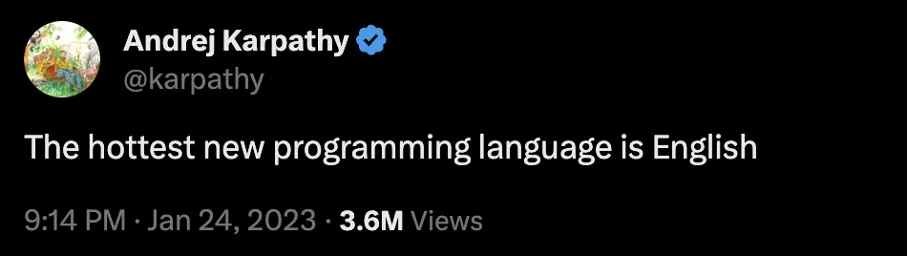

Nicht nur konnte ChatGPT natürliche Konversationen mit bis zu 3000 Wörtern führen – es entpuppte sich als vielversprechender Assistent für eine Reihe alltäglicher Aufgaben. Verpackt in eine zugängliche Web-Applikation markierte die Veröffentlichung von ChatGPT eine Zäsur in der KI- und Technologiegeschichte. Statt Automatisierung den IT-Expert:innen zu überlassen, konnten Bürotätigkeiten wie das Schreiben von E-Mails oder das Zusammenfassen von Texten nun individualisiert und selbstbestimmt von Durchschnittsuser:innen nach Bedarf teilautomatisiert werden. Nicht umsonst schrieb Andrej Karpathy, Gründungsmitglied von OpenAI und ehemaliger AI-Direktor von Tesla, bei Twitter:

Multimodale Generative KI

Doch wer bei moderner generativer KI nur an Texte denkt, lässt die beeindruckende Entwicklung multimodaler GenAI-Modelle unerwähnt. Seit April 2022 lassen sich mit DALL-E 2 anhand kurzer Textprompts realistische Zeichnungen, Kunstwerke und Fotografien generieren. Kommerzielle GenAI-Plattformen wie RunwayML bieten seit Februar 2023 sogar die Möglichkeit, Bilder mit KI zum Leben zu erwecken oder gar komplette Videos allein auf Basis von Textprompts zu generieren. Wenig überraschend also, dass auch das Erstellen von Musik oder Soundeffekten mit KI blitzschnell und für jeden zugänglich wird. Frühe Modelle wie Googles MusicLM (Januar 2023) oder Metas AudioGen (August 2023) lieferten noch keine Sounds in Studioqualität, zeigten aber bereits das Potential der Technologie auf. Der große Durchbruch von GenAI für Audio kam im Frühjahr 2024, als Suno, Udio und Elevenlabs hochqualitative Songs und Sounds generierten und eine große Debatte um Urheberrecht und Fair Use entfachten.

Wer profitiert?

Bei all diesen mächtigen KI-Modellen stellt sich die Frage, wer von diesen neuen Technologien profitiert. Sind es wieder nur große Tech-Konzerne, die insbesondere in Sachen Datenschutz keinen guten Ruf genießen? Die Antwort ist: teils, teils. Zwar werden große Durchbrüche häufig noch von Microsoft, Google und Co. angeführt, aber kleinere, frei verfügbare Modelle, sogenannte Open-Source-Modelle, erzielen zunehmend große Erfolge. Das Sprachmodell des französischen Startups Mistral AI konnte so zuletzt OpenAIs GPT-3.5 in den üblichen Testmetriken schlagen – und das mit einem wesentlich ressourcenschonenderen und schnelleren Modell als der Konkurrent aus dem Silicon Valley. Mit Meta gehört auch einer der größten Tech-Konzerne der Welt zu den führenden Open-Source-Entwicklern, unter anderem mit ihren Llama-Modellen. Wer sich allgemein verfügbare, private KI-Assistenten wünscht, kann sich auf eine rosige Zukunft freuen.

Herausforderungen und Chancen

Die dritte Phase der Geschichte von GenAI ist gekennzeichnet durch die breite Verfügbarkeit hochperformanter KI-Modelle, entweder durch kommerzielle Web-Applikationen und Plattformen oder durch frei verfügbare Open-Source-Modelle. Unternehmen wird zunehmend klar, dass die Wertschöpfung durch KI nicht nur an die Verfügbarkeit hochqualifizierter IT-Expert:innen geknüpft ist. Vielmehr gilt es, den durch KI geschaffenen Nutzen über die breite Anwendung vorhandener Technologien zu maximieren. Dabei stellen sich weiterhin zahlreiche Herausforderungen, die unter anderem die Sicherheit der Eingabe- und Ausgabedaten oder die Fairness der KI-Entscheidungen betreffen.

Wie kommen wir auf das nächste Level?

Ein Schlüssel zum Erfolg dieser Epoche ist das Paradigma des „Plug & Play“. Das heißt, Modelle wie ChatGPT und DALL-E 2 können einfach und ohne tiefgehende technische Kenntnisse genutzt werden. Diese Modelle sind durch „Reinforcement Learning from Human Feedback” (RLHF) und API-Schnittstellen leicht zugänglich. Die Aussage von Andrej Karpathy, dass „die heißeste neue Programmiersprache Englisch ist“, unterstreicht die Demokratisierung der KI-Nutzung.

Ein weiterer wichtiger Aspekt ist die Finetuning von Modellen auf menschliche Präferenzen, was die Benutzerfreundlichkeit und Anwendbarkeit erheblich verbessert hat. Gleichzeitig erleben Open-Source-Modelle einen Boom, da sie auf normalen Computern laufen und somit einer breiteren Nutzerschaft zugänglich sind.

Ethische und rechtliche Fragen stehen ebenfalls im Fokus, insbesondere im Umgang mit Third-Party-GenAI und eigenen Modellen. Themen wie Bias und Fairness sind nicht zu unterschätzen, da sie die Akzeptanz und Integrität der KI-Anwendungen maßgeblich beeinflussen.

What’s next?

Im nächsten Teil unserer Serie wagen wir einen Blick in die Zukunft von generativer KI. Verpassenicht, wie wir die zukünftigen Herausforderungen und Chancen in der Welt der generativen Künstlichen Intelligenz beleuchten.

Verpasse nicht Teil 4 unserer Blogserie.